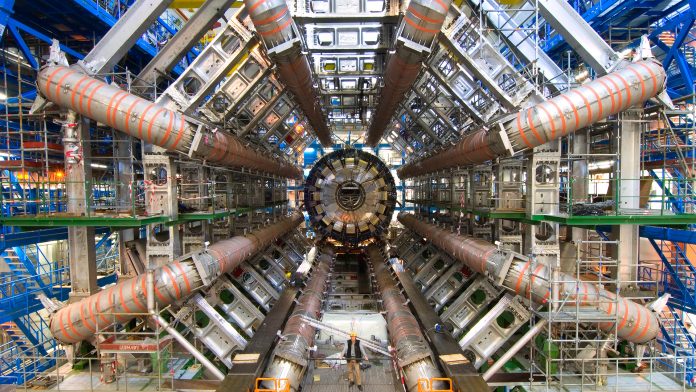

El LHC (Gran Colisionador de Hadrones) es el acelerador de partículas más grande y de mayor energía que existe en el mundo, ubicado en el CERN (Organización Europea para la Investigación Nuclear), en el que varios grupos del Instituto de Física Corpuscular, centro mixto del CSIC y la Universitat de València, trabajan activamente.

A principios de este siglo, los experimentos del LHC buscaron la mejor solución para varios retos: abordar un desafío de procesamiento de datos de varios petabytes sin precedentes, proporcionar una infraestructura en continuo crecimiento y adaptativa que da servicio a más de 6.000 científicos de 200 universidades y laboratorios en 45 países, las 24 horas del día, y analizar los datos del LHC en busca de nuevos descubrimientos.

Para hacer frente a estos retos, se han llevado a cabo una serie de iniciativas centradas en formar una malla mundial de nodos informáticos (GRID Computing) comunicados a través de una serie de protocolos de software.

La solución de Computación Distribuida GRID se convirtió en una realidad y se implementó de manera efectiva alrededor de 2003. Desde entonces los miembros de los experimentos del LHC pueden enviar sus trabajos, los cuales requieren el procesamiento de gran cantidad de datos, desde diferentes sitios distribuidos geográficamente en todo el mundo.

La coordinación entre centros fue un aspecto muy importante para su organización y para ello LHC optó por un sistema “escalonado” de manera que quedara en tres niveles: Tier 0 en el CERN, Tier 1 en varios sitios regionales y centros de Tier2 con muy buena conectividad entre ellos. Esto supuso el nacimiento del proyecto Worldwide LHC Computing Grid (WLCG).

El WLCG es una colaboración compuesta por más de 170 centros informáticos distribuidos en 42 países, que conectan infraestructuras de red nacionales e internacionales. Entre ellos, el IFIC y el departamento de Física Atómica, Molecular y Nuclear de la Universitat de Valencia participan con un Tier2 desde la primera ejecución. Por ende, también forman parte de la “cloud ibérica”, una región donde hay recursos tanto de cálculo como de almacenamiento para el procesado y análisis de datos del LHC, y cuenta con un Tier1 y varios Tier2s, proporcionando recursos informáticos a la colaboración del experimento ATLAS, otro de los principales experimentos del CERN.

El objetivo principal del WLCG es construir y mantener una infraestructura informática distribuida para almacenar, distribuir y analizar los datos de los experimentos del LHC. El WLCG cuenta con el apoyo de muchos proyectos GRID, como LHC Computing Grid (LCG), European Grid Initiative (EGI), NorduGrid – Advanced Resource Connector (ARC) y Open Science Grid (OSG), entre otros.

Otra área del LHC que también se basa en el uso de datos recopilados algo diferente al anteriormente mencionado pero no menos importante, es la obtención del conocimiento de estos datos mediante la aplicación de técnicas de aprendizaje automático / aprendizaje profundo, a través de técnicas de Inteligencia Artificial (IA) y el Machine Learnig (ML).

Estas herramientas se están aplicando en varios aspectos de la física de altas energías, en particular en los experimentos del LHC en sistemas de activación y adquisición de datos, en desafíos informáticos, simulación de eventos, reconstrucción, rendimiento de detectores, análisis de física, entre otros.

El grupo del IFIC hace uso de estas herramientas para la mejora de las medidas de observables y la búsqueda de Nueva Física, centrándonos en las actividades de análisis de física y simulación de las colisiones en ATLAS.

Por un lado, el grupo ha mejorado la eficiencia de clasificación para la separación de sucesos que implican Nueva Física respecto al fondo del Modelo Standard aplicando técnicas supervisadas y no supervisadas de ML. Por otro lado, se producen grandes cantidades de datos simulados mediante métodos de Deep Learning, aprendizaje profundo, para su utilización en el análisis de física con el valor añadido de un coste menor en tiempo de computación.

Para estos estudios se han utilizado librerías de ML de código abierto que nos abren una perspectiva de implementación más ágil y versátil.

Además, el grupo del IFIC ha podido utilizar ARTEMISA, una infraestructura muy avanzada disponible en el instituto. ARTEMISA significa «Entorno ARTificial para Machine Learning e Innovación en Computación Científica Avanzada» y está ubicado en el Centro de Computación IFIC. Es un nuevo equipo dedicado a técnicas de IA como ML y Big Data y funciona de forma continua gracias a su sistema por lotes. Los usuarios pueden desarrollar y probar sus programas y enviar sus trabajos a 23 máquinas con procesadores GPU.

ARTEMISA está abierto a todos los grupos científicos afiliados a cualquier universidad pública o institución de investigación española.